贝博真人百家乐如何提现_数仓 | 几种常见的数据同步方式

发布日期:2023-10-24 06:13 点击次数:150

本文转载自微信公众号「大数据时代与数仓 」,作家西贝。转载本文请有关大数据时代与数仓公众号。

写在前边数据仓库的特质之一是集成,即最初把未经过加工处理的、不同开始的、不同模样的数据同步到ODS层,一般情况下,这些ODS层数据包括日记数据和业务DB数据。对于业务DB数据而言(比如存储在MySQL中),将数据鸠合并导入到数仓中(平方是Hive或者MaxCompute)瑕瑜常蹙迫的一个要道。

贝博真人百家乐那么,该何如将业务DB数据高效准确地同步到数仓中呢?一般企业会使用两种决议:直连同步与及时增量同步(数据库日记理解)。其中直连同步的基本想路是直连数据库进行SELECT,然后将查询的数据存储到腹地文献行动中间存储,终末把文献Load到数仓中。这种方式十分的简便便捷,然而跟着业务的发展,会遭逢一些瓶颈,具体见下文分析。

为了措置这些问题,一般会使用及时增量的方式进行数据同步,其基开心趣是CDC (Change Data Capture) + Merge,即及时Binlog鸠合 + 离线处理Binlog规复业务数据这么一套措置决议。

本文主要包括以下骨子,但愿对你有所匡助

常见数据同步方式 流式数据集成 数据同步的方式 直连同步直连同步是指通过界说好的范例接口API和基于动态清爽库的方式径直联结业务库,比如ODBC/JDBC等轨则了调和的标准接口,不同的数据库基于这套标准提供范例的运行,从而援救彻底疏通的函数调用和SQL结束。比如频繁使用的Sqoop便是遴选这种方式进行批量数据同步的。

如何提现皇冠信用盘登3出租直连同步的方式竖立十分简便,很容易上手操作,比拟符合操作型业务系统的数据同步,然而会存在以下问题:

皇冠模拟盘口 数据同步时期:跟着业务限制的增长,数据同步破耗的时期会越来越长,无法骄矜卑劣数仓出产的时期条目。 性能瓶颈:直连数据库查询数据,对数据库影响十分大,容易形成慢查询,如若业务库莫得遴选主备计谋,则会影响业务线上的正燕做事,如若遴选了主备计谋,固然不错幸免对业务系统的性能影响,但当数据量较大时,性能照旧会很差。

所谓日记理解,即理解数据库的变更日记,比如MySQL的Binlog日记,Oracle的存档日记文献。通过读取这些日记信息,收罗变化的数据并将其理解到盘算存储中即可完成数据的及时同步。这种读操作是在操作系统层面完成的,不需要通过数据库,因此不会给源数据库带来性能上的瓶颈。

皇冠A盘B盘C盘数据库日记理解的同步方式不错完巩固时与准及时的同步,蔓延不错贬抑在毫秒级别的,其最大的上风便是性能好、后果高,不会对源数据库形成影响,现在,从业务系统到数据仓库中的及时增量同步,平常遴选这种方式。天然,这种方式也会存在一些问题,比如批量补数时形成无数数据更新,日记理解会处理较慢,形成数据蔓延。除此以外,这种方式比拟复杂,参加也较大,欧博娱乐代理因为需要一个及时的抽取系统去抽取并理解日记,下文会对此进行详确讲明。

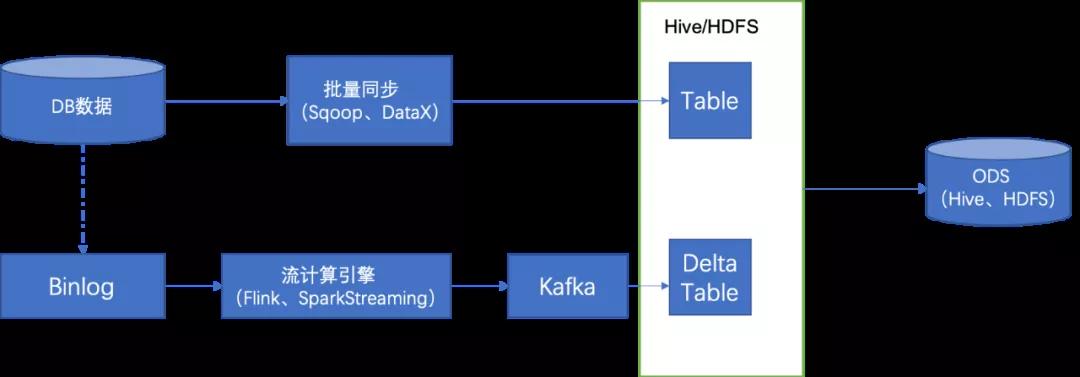

如上图所示架构,在直连同步基础之上加多了流式同步的链路,经过流式推敲引擎把相应的 Binlog 鸠合到 Kafka,同期会经过一个 Kafka 2Hive 的范例把它导入到原始数据,再经过一层 Merge,产出卑劣需要的 ODS 数据。

上述的数据集成方式上风瑕瑜常较着的,把数据传输的时期放到了 T+0 这一天去作念,在第二天的时候只需要去作念一次 merge 就不错了。十分检朴时期和推敲资源。

皇冠客服飞机:@seo3687 流式数据集成结束 结束想路

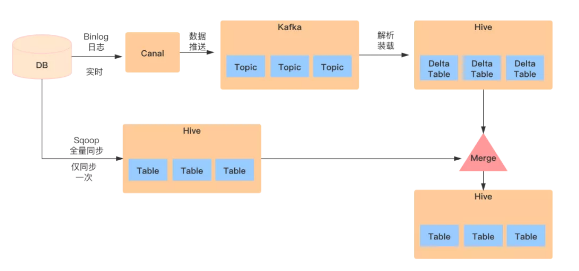

最初,选拔Flink认真把Kafka上的Binlog数据拉取到HDFS上,生成增量表。

然后,对每张ODS表,最初需要一次性制作快照(Snapshot),把MySQL里的存量数据读取到Hive上,这一过程底层选拔直连MySQL去Select数据的方式,不错使用Sqoop进行一次性全量导入,生成一张全量表。

终末,对每张ODS表,每天基于存量数据和本日增量产生的Binlog作念Merge,从而规复出业务数据。

Binlog是流式产生的,通过对Binlog的及时鸠合,把部分数据处理需求由每天一次的批处理分管到及时流上。不管从性能上照旧对MySQL的拜访压力上,皆会有较着地改善。Binlog自己记载了数据变更的类型(Insert/Update/Delete),通过一些语义方面的处理,彻底冒昧作念到精确的数据规复。

对于Binlog理解部分,不错使用canal用具,鸠合到Kafka之后,不错使用Flink理解kafka数据并写入到HDFS上,理解kafka的数据不错使用Flink的DataStreamAPI,也不错使用FlinkSQL的canal-json数据源形式进行理解,使用FlinkSQL相对来说是比拟简便的。底下是canal-json形式的kafka数据源。

CREATE 彩票炸金花TABLE region ( id BIGINT, region_name STRING ) WITH ( 'connector' = 'kafka', 'topic' = 'mydw.base_region', 'properties.bootstrap.servers' = 'kms-3:9092', 'properties.group.id' = 'testGroup', 'format' = 'canal-json' , 'scan.startup.mode' = 'earliest-offset' );

数据理解完成之后,底下的便是兼并规复齐全数据的过程,对于兼并规复数据,一种比拟常见的方式便是全外联结(FULL OUTER JOIN)。具体如下:

生成增量表与全量表的Merge任务,本日的增量数据与昨天的全量数据进行全外联结,该Merge任务的基本逻辑是:

INSERT OVERWRITE TABLE user_order PARTITION(ds='20211012') SELECT CASE WHEN n.id IS NULL THEN o.id ELSE n.id END ,CASE WHEN n.id IS NULL THEN o.create_time ELSE n.create_time END ,CASE WHEN n.id IS NULL THEN o.modified_time ELSE n.modified_time END ,CASE WHEN n.id IS NULL THEN o.user_id ELSE n.user_id END ,CASE WHEN n.id IS NULL THEN o.sku_code ELSE n.sku_code END ,CASE WHEN n.id IS NULL THEN o.pay_fee ELSE n.pay_fee END FROM ( SELECT * FROM user_order_delta WHERE ds = '20211012' AND id IS NOT NULL AND user_id IS NOT NULL ) n FULL OUTER JOIN (-- 全外联结进行数据merge SELECT * FROM user_order WHERE ds = '20211011' AND id IS NOT NULL AND user_id IS NOT NULL ) o ON o.id = n.id AND o.user_id = n.user_id ;

经过上述治安,即可将数据规复齐全。

看到XXX在比赛中不停奔跑,不停努力,我被他的精神所打动。他的出色表现不仅带给了球迷们欢呼和激情,更是给我们带来了无尽的想象力。我相信,在未来的比赛中,他会有更加出色的表现。 纪念本文最初先容了数据仓库构建ODS层常见的数据同步方式,并对每种方式进行了讲明,给出了相对应的清晰图。接着给出了CDC+Merge的数据同步决议。值得郑重的是,Flink1.11引入了CDC的connector,比如MySQL CDC和Postgres CDC,同期对Kafka的Connector援救canal-json和debezium-json以及changelog-json的format,通过这种方式不错很便捷地拿获变化的数据,大大简化了数据处理的进程和数据同步的复杂度。

皇冠体育

上一篇:没有了 下一篇:太平洋平台博彩平台注册送免费彩票_天官赐福第二季开播!好音信:开播了 坏音信:看不了